行動データ観察によるユーザー理解。

モバイルアプリのアクセスログや店舗での購買履歴など、あらゆるユーザー行動がデータ化されています。今後は5GやIoTの普及により、生体データや撮影データなどが集約され、さらにビッグデータ化されていくことでしょう。ただ、データは貯めているだけでは何の価値も生みません。分析し、有用な知識を獲得してこそ意味があります。

また、多くのマーケターやビジネスパーソンにとって、ユーザーの行動データから、購買の意思決定プロセスを把握したい、思いもよらないニーズを発見したい、というのは、データ活用におけるもっとも重要な関心ごとのひとつでしょう。

あるコンテンツXの閲覧(事象X)と、ある商品Yの購買(事象Y)には、強い共起性があるから、事象Yの意思決定に事象Xがなんらか関与している可能性が高いのではないか。そのような分析はよく行われることと思います。購買という結果につながる原因がわかれば、さらなる購買向上にむけた対策を講じることが可能となります。二つの事象間の因果関係を明らかにする考え方や手法には因果推論(Causal Inference)1)いまさら聞けない因果推論やベイズ推定(Bayesian Inference)2)いまさら聞けないベイズ推定などがありますが、簡単ではありません。

一方で、一人ひとりの行動データをミクロ視点で観察し、時系列に追うことで、ユーザーの意思決定プロセスの理解や発見が進むことがあります。クロスハックではこれをデータエスノグラフィ(Data Ethnography)3)データエスノグラフィって?と呼んでいます。エスノグラフィとは、生活者のありのままの行動を観察することで、アンケートやインタビューからは得られない洞察や発見の獲得を目指す手法のことですが、これはそのデータ版と言えます。

そこで今回は、データエスノグラフィ実践の入門編をご紹介したいと思います。なお、分析ツールはGoogle BigQueryとTableau Desktopを用いて進めます。それぞれについては「BigQueryではじめるSQL」「TableauではじめるBI」を参照してください。

データエスノグラフィの手順。

データエスノグラフィは以下の手順で進めます。

- 分析の背景の整理と目的の明確化

- データ準備と基礎分析

- ユーザーの分類と選定

- 行動データの観察

- 代表性の検証

データ分析に限らず、何らかの課題解決をするには、まずその背景を整理し、目的を明確化する必要があります。当たり前の話ですが、失敗するデータ分析の多くは、ここをあいまいにしたまま、とにかく何らかの有用な知識を獲得したいという思いのみで行われており、時間とコストを浪費する結果となっています。

また、データは「存在する」状態と「分析できる」状態では全く異なります。そして多くのデータは分析することを目的に収集されておらず、そもそも構造化されていない、あるいは欠損・異常値・表記揺れ(同義だが異句の状態)を含むこともあります。それらを加工し「分析できる」状態にすることをデータ準備(Data Preparation)といいます。

さらに、あまねく全てのデータを準備することはできないため、必然的に選択が行われ、偏りが必ず発生します。これを選択バイアス(Selection Bias)といいます。例えば、プリペイドカードの購買履歴には、カードの入金額の上限を超える高額商品の購買履歴がそもそも含まれていません。おそらくクレッジトカードなどの他の決済手段で購買しているのでしょう。このような偏りのあるデータで無邪気にRFM分析などを行うと、ミスリード(Misslead)を起こします。

選択バイアスを無くすことが理想ですが、現実には不可能であるため、データの全体像を俯瞰して分布と偏りを把握し、分析を進める上での前提条件として捉えておくことが重要です。その作業を基礎分析(Basic Analysis)といいます。

ここまで完了してようやくデータエスノグラフィが実施可能となるわけですが、とはいえすべてのユーザーの行動を観察するわけには行きません。そこで、似たユーザーをセグメント(Segment)に分類し、観察すべきセグメントを選定します。

観察すべきセグメントが決まれば、その中から数名のユーザーを抽出し、一人ひとりの行動データをミクロ視点で観察し、何人かに共通して見られる典型的な行動パターンを分析します。例えば、アパレルのモバイルアプリのアクセスログと店舗での購買履歴のデータであれば、「来店前に会員向け先行情報を閲覧」「来店中にポイントを確認」「来店後にコーディネート機能を利用」などの行動パターンを捉えていきます。

これがわかれば、先行情報を閲覧したセグメントは、閲覧しなかったセグメントと比べて購買しているかという疑似実験(Quasi Experiment)を行うことで、先行情報の因果効果を明らかにする因果推論が可能となります。

ただし、行動観察から捉えた行動パターンは、観察したその数名にのみ見られるものかもしれません。そこで代表性の検証が必要となります。代表性(Representativeness)とは、調査対象者全体の中から抽出された一部の対象者の調査結果が、調査対象者全体の結果を、偏りなく正確に反映出来ているかどうかのことです。(※代表性の検証の方法は最終回に説明)

ECサイトの継続率をどう上げるか。

では、データエスノグラフィの実践を進めて行きましょう。まずは分析の背景の整理と目的の明確化を行います。

あなたは、とある総合ECサイトの責任者です。ECサイトでは、F2転換率が重要であると言われています。この”F”は購買頻度(Frequency)のことで、F2転換率とは初回購買から二回目購買への転換率(Conversion Rate)を意味します。一般的に、新規会員の獲得よりも、既存会員のリピート購買促進のほうがコスト効率が高いため、F2転換率は重要な指標となります。とはいえF2転換した会員が、その後も継続的に購買してくれる、いわゆる優良会員になるとは限りません。

そこで今回の分析目的を「優良化する会員の行動特性を、購買履歴データから把握する」とします。なおそこには、まだ優良化していな会員を意図的に優良化するためのヒントがあることは言うまでもありません。

分析対象データは、とある総合ECサイトの会員の購買履歴データで、概要は以下のとおりです。

- 種類:総合ECサイトの会員の購買履歴

- 期間:2005年1月〜2013年12月(9年間)

- 会員数:639,777人

- 購買数:7,599,650件(平均11.9件/人)

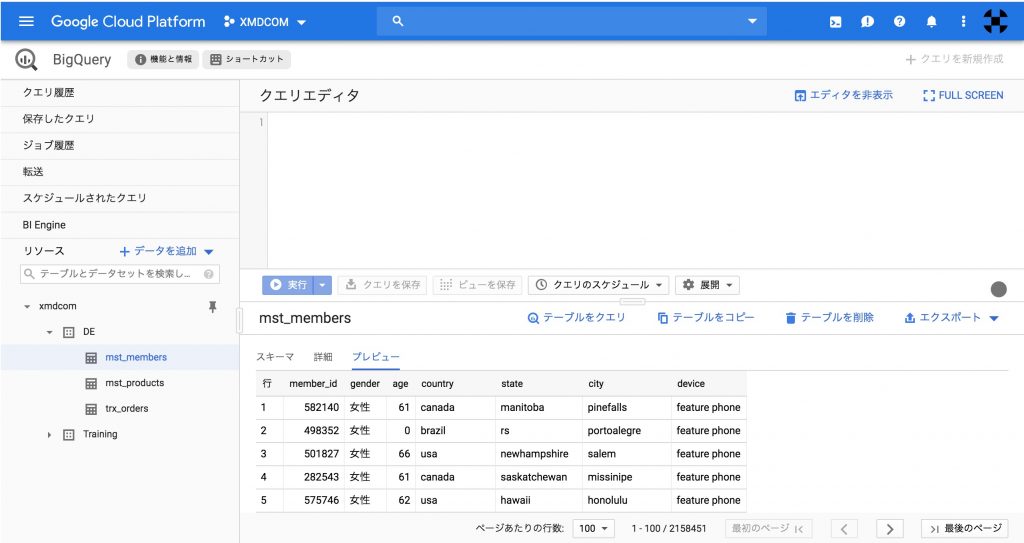

データソースは以下の3つを使用します。

| データソース | 変数 | ダウンロード |

| 会員マスタ mst_members |

会員ID, 年齢, 性別, 居住地など | [↓]105MB |

| 商品マスタ mst_products |

商品ID, 商品カテゴリなど | [↓]53MB |

| 購買履歴 trx_orders |

会員ID, 商品ID, 注文日, 価格 | [↓]698MB |

まずはこれらのデータをBigQueryに投入します。データセット名とテーブル名は任意ですが、この後の解説で使う名前と合わせておきたい方は、データセット名を「DE」、テーブル名はファイル名をそのまま設定しておきましょう。投入が完了すると、このような状態になります。

次回は、データ準備と基礎分析について見て行きます。

関連する記事

須川 敦史

UX&データスペシャリスト

クロスハック 代表 / uxmeetsdata.com 編集長

脚注

| 1. | ↑ | いまさら聞けない因果推論 |

| 2. | ↑ | いまさら聞けないベイズ推定 |

| 3. | ↑ | データエスノグラフィって? |